如何安裝spark依賴yarn執(zhí)行

這篇文章將為大家詳細(xì)講解有關(guān)如何安裝spark依賴yarn執(zhí)行,小編覺得挺實(shí)用的,因此分享給大家做個(gè)參考,希望大家閱讀完這篇文章后可以有所收獲。

創(chuàng)新互聯(lián)是一家集網(wǎng)站建設(shè),新建企業(yè)網(wǎng)站建設(shè),新建品牌網(wǎng)站建設(shè),網(wǎng)站定制,新建網(wǎng)站建設(shè)報(bào)價(jià),網(wǎng)絡(luò)營(yíng)銷,網(wǎng)絡(luò)優(yōu)化,新建網(wǎng)站推廣為一體的創(chuàng)新建站企業(yè),幫助傳統(tǒng)企業(yè)提升企業(yè)形象加強(qiáng)企業(yè)競(jìng)爭(zhēng)力。可充分滿足這一群體相比中小企業(yè)更為豐富、高端、多元的互聯(lián)網(wǎng)需求。同時(shí)我們時(shí)刻保持專業(yè)、時(shí)尚、前沿,時(shí)刻以成就客戶成長(zhǎng)自我,堅(jiān)持不斷學(xué)習(xí)、思考、沉淀、凈化自己,讓我們?yōu)楦嗟钠髽I(yè)打造出實(shí)用型網(wǎng)站。

由于之前安裝hadoop版本是3.30 所以這里下載spark3

spark下載地址 包含了對(duì)應(yīng)hadoop3的jar包 http://archive.apache.org/dist/spark/spark-3.0.1/spark-3.0.1-bin-hadoop3.2.tgz

完成之后解壓 tar -zxvf spark-3.0.1-bin-hadoop3.2.tgz mv spark-3.0.1-bin-hadoop3.2 spark-3

修改hadoop配置文件/opt/module/hadoop/etc/hadoop/yarn-site.xml, 并分發(fā)

修改hadoop配置文件/opt/module/hadoop/etc/hadoop/yarn-site.xml, 并分發(fā) <!--是否啟動(dòng)一個(gè)線程檢查每個(gè)任務(wù)正使用的物理內(nèi)存量,如果任務(wù)超出分配值,則直接將其殺掉,默認(rèn)是true --> <property> <name>yarn.nodemanager.pmem-check-enabled</name> <value>false</value> </property> <!--是否啟動(dòng)一個(gè)線程檢查每個(gè)任務(wù)正使用的虛擬內(nèi)存量,如果任務(wù)超出分配值,則直接將其殺掉,默認(rèn)是true --> <property> <name>yarn.nodemanager.vmem-check-enabled</name> <value>false</value> </property>

修改配置文件 spark-env.sh

#jdk路徑 export JAVA_HOME=/bigdata/jdk1.8.0_161 #yarn路徑 YARN_CONF_DIR=/bigdata/hadoop-3.3.0/etc/hadoop #歷史服務(wù)配置 export SPARK_HISTORY_OPTS=" -Dspark.history.ui.port=18080 -Dspark.history.fs.logDirectory=hdfs://hadoop1:9000/directory -Dspark.history.retainedApplications=30"

修改 spark-defaults.conf

spark.eventLog.enabled true #hdfs地址 路徑是先建好的 hdfs dfs -mkdir /directory spark.eventLog.dir hdfs://hadoop1:9000/directory #歷史服務(wù)的web地址 spark.yarn.historyServer.address=hadoop1:18080 spark.history.ui.port=18080 #jar包托管在hdfs中的地址 spark.yarn.jars hdfs://hadoop1:9000/hadoop/spark_jars/*

將spark整合hadoop3的jar包傳到hdfs上

hdfs dfs -mkdir /hadoop hdfs dfs -mkdir /hadoop/spark_jars hdfs dfs -put /usr/local/spark-3/jars/* /hadoop/spark_jars

啟動(dòng)歷史服務(wù) sbin/start-history-server.sh

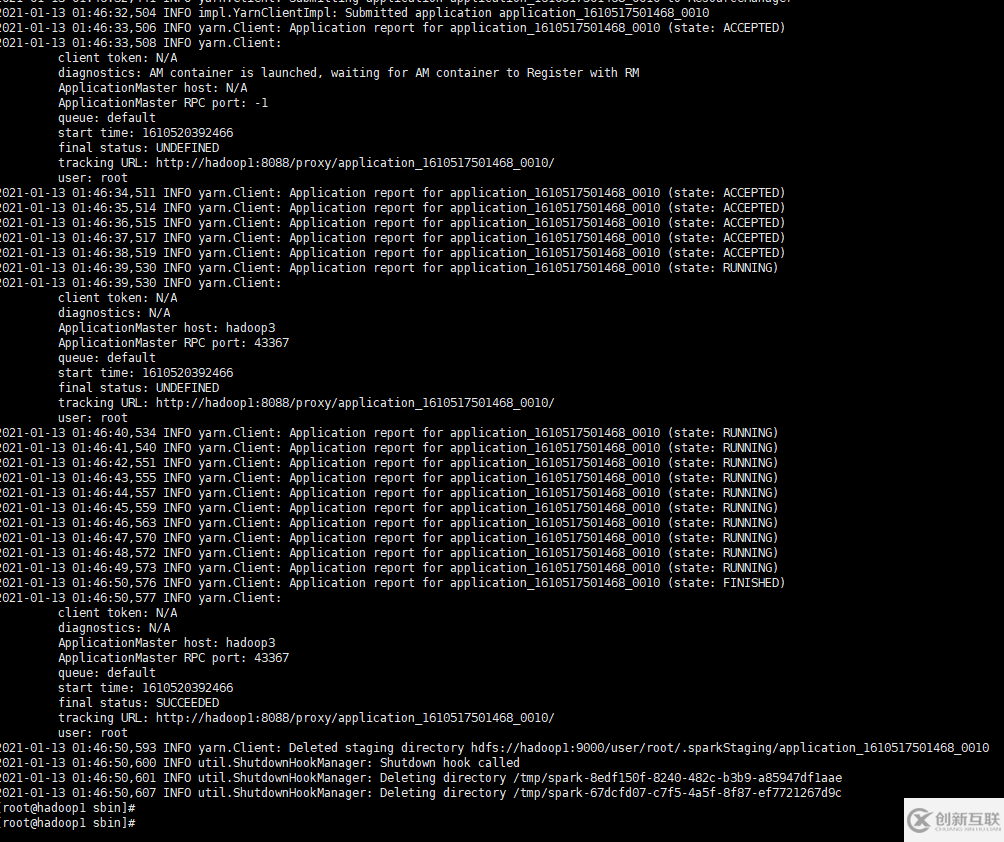

訪問ui沒有問題后創(chuàng)建一個(gè)測(cè)試任務(wù)

/bigdata/spark/bin/spark-submit --class mapTest --master yarn --driver-memory 512m --executor-memory 512m --deploy-mode cluster /spark-demo.jar

完成

關(guān)于“如何安裝spark依賴yarn執(zhí)行”這篇文章就分享到這里了,希望以上內(nèi)容可以對(duì)大家有一定的幫助,使各位可以學(xué)到更多知識(shí),如果覺得文章不錯(cuò),請(qǐng)把它分享出去讓更多的人看到。

網(wǎng)頁(yè)題目:如何安裝spark依賴yarn執(zhí)行

文章網(wǎng)址:http://chinadenli.net/article2/jggdoc.html

成都網(wǎng)站建設(shè)公司_創(chuàng)新互聯(lián),為您提供營(yíng)銷型網(wǎng)站建設(shè)、自適應(yīng)網(wǎng)站、App開發(fā)、網(wǎng)站導(dǎo)航、商城網(wǎng)站、全網(wǎng)營(yíng)銷推廣

聲明:本網(wǎng)站發(fā)布的內(nèi)容(圖片、視頻和文字)以用戶投稿、用戶轉(zhuǎn)載內(nèi)容為主,如果涉及侵權(quán)請(qǐng)盡快告知,我們將會(huì)在第一時(shí)間刪除。文章觀點(diǎn)不代表本網(wǎng)站立場(chǎng),如需處理請(qǐng)聯(lián)系客服。電話:028-86922220;郵箱:631063699@qq.com。內(nèi)容未經(jīng)允許不得轉(zhuǎn)載,或轉(zhuǎn)載時(shí)需注明來源: 創(chuàng)新互聯(lián)

- 如何提升「網(wǎng)站的收錄量」? 2015-12-30

- 新網(wǎng)站的排名和收錄快速增長(zhǎng)的方法 2015-10-17

- SEO優(yōu)化怎么去做才能讓百度收錄 2016-10-29

- 對(duì)百度收錄有益的幾條外部因素 2016-11-03

- 收錄量和收錄速度是網(wǎng)站獲得好排名的關(guān)鍵嗎? 2015-10-03

- 新網(wǎng)站不收錄的原因有哪些呢? 2016-10-26

- 如何利用長(zhǎng)尾詞實(shí)現(xiàn)快速收錄 2014-03-20

- 網(wǎng)站收錄和排名之間有何微妙關(guān)系? 2020-07-24

- 網(wǎng)站地圖格式如何優(yōu)化對(duì)頁(yè)面收錄有利? 2015-12-17

- 關(guān)鍵詞seo優(yōu)化:影響頁(yè)面收錄的因素有哪些 2016-04-13

- 成都SEO服務(wù):解釋文章不被收錄原因 2016-11-14

- 網(wǎng)站頁(yè)面百度沒收錄要提交死鏈嗎? 2016-05-02