zeppelin中怎么配置spark

本篇文章給大家分享的是有關zeppelin中怎么配置 spark,小編覺得挺實用的,因此分享給大家學習,希望大家閱讀完這篇文章后可以有所收獲,話不多說,跟著小編一起來看看吧。

成都網(wǎng)站建設哪家好,找創(chuàng)新互聯(lián)公司!專注于網(wǎng)頁設計、成都網(wǎng)站建設公司、微信開發(fā)、小程序開發(fā)、集團企業(yè)網(wǎng)站設計等服務項目。核心團隊均擁有互聯(lián)網(wǎng)行業(yè)多年經(jīng)驗,服務眾多知名企業(yè)客戶;涵蓋的客戶類型包括:紗窗等眾多領域,積累了大量豐富的經(jīng)驗,同時也獲得了客戶的一致贊揚!

修改zeppelin 配置文件

在zeppelin-env.sh中添加spark路徑和hadoop配置文件路徑

export SPARK_HOME=/usr/lib/spark export HADOOP_CONF_DIR=/usr/lib/hadoop

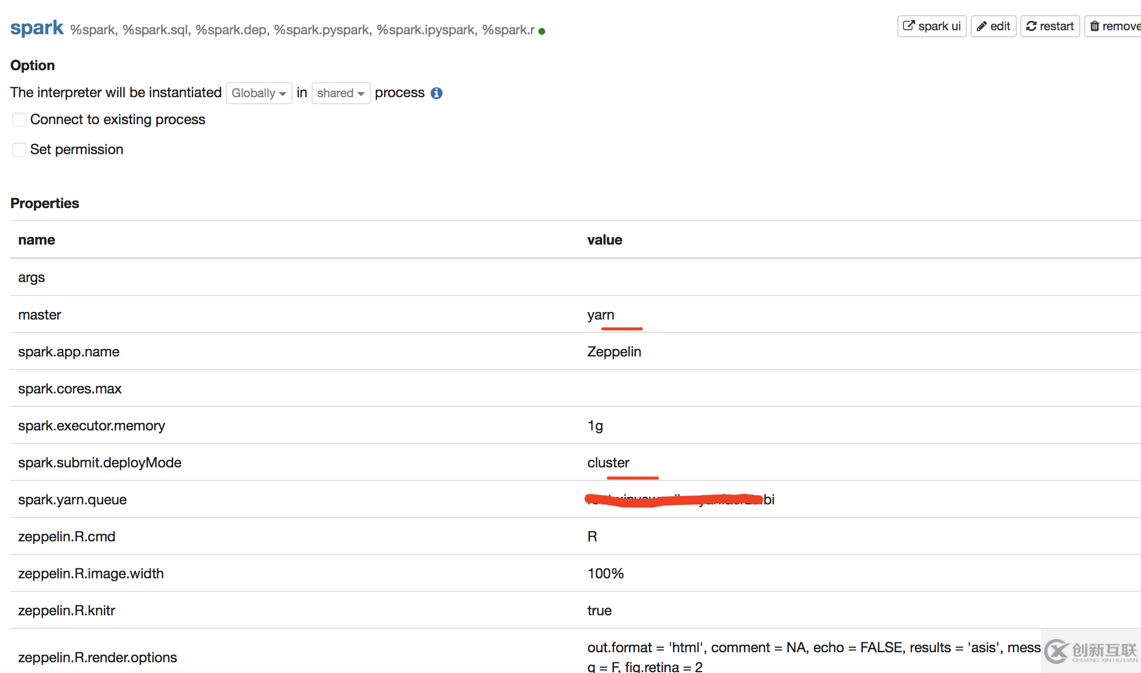

修改spark interpreter參數(shù)

master 可以為:

local[*] in local mode spark://master:7077 in standalone cluster yarn-client in Yarn client mode yarn-cluster in Yarn cluster mode mesos://host:5050 in Mesos cluster

我這里是 spark on yarn 所以我配置的 master 為yarn,提交模式為 cluster,我設置為 client 的時候運行任務一直卡著不動

排錯

我這里是在docker里搭建的,中間還報了其它的錯

java.lang.RuntimeException: org.apache.zeppelin.interpreter.InterpreterException: org.apache.thrift.transport.TTransportException: java.net.ConnectException: Connection refused

后來發(fā)現(xiàn)是AM無法實例化的原因

host -i

發(fā)現(xiàn)docker 里是一個虛擬ip

解決方法:

啟動docker時指定網(wǎng)絡連接方式

host模式 : docker run 使用 --net=host指定 docker使用的網(wǎng)絡實際上和宿主機一樣

以上就是zeppelin中怎么配置 spark,小編相信有部分知識點可能是我們日常工作會見到或用到的。希望你能通過這篇文章學到更多知識。更多詳情敬請關注創(chuàng)新互聯(lián)行業(yè)資訊頻道。

文章名稱:zeppelin中怎么配置spark

轉載源于:http://chinadenli.net/article22/jggjcc.html

成都網(wǎng)站建設公司_創(chuàng)新互聯(lián),為您提供動態(tài)網(wǎng)站、企業(yè)網(wǎng)站制作、手機網(wǎng)站建設、網(wǎng)站設計、外貿網(wǎng)站建設、網(wǎng)站改版

聲明:本網(wǎng)站發(fā)布的內容(圖片、視頻和文字)以用戶投稿、用戶轉載內容為主,如果涉及侵權請盡快告知,我們將會在第一時間刪除。文章觀點不代表本網(wǎng)站立場,如需處理請聯(lián)系客服。電話:028-86922220;郵箱:631063699@qq.com。內容未經(jīng)允許不得轉載,或轉載時需注明來源: 創(chuàng)新互聯(lián)

- 高端品牌網(wǎng)站建設應該怎么做,企業(yè)品牌網(wǎng)站建設方案策劃? 2016-09-06

- 品牌網(wǎng)站建設方案要怎么做? 2022-12-08

- 所謂品牌網(wǎng)站建設沒有我們想的簡單與復雜! 2022-08-22

- 品牌網(wǎng)站建設公司通過什么方式打響品牌 2022-10-14

- 品牌網(wǎng)站建設要注意的問題 2021-11-18

- 品牌網(wǎng)站建設的核心宗旨-建立品牌形象 2015-10-04

- 品牌網(wǎng)站建設什么內容重要? 2022-03-22

- 品牌網(wǎng)站建設有哪些費用,設計網(wǎng)頁多少錢? 2021-01-07

- 品牌網(wǎng)站建設公司如何做專業(yè) 2017-06-16

- 服裝行業(yè)品牌網(wǎng)站建設需要注意哪些因素? 2021-06-12

- 品牌網(wǎng)站建設中小企業(yè)要如何才能實現(xiàn)品牌網(wǎng)站的建設 2023-03-20

- 優(yōu)秀的品牌網(wǎng)站建設制作需要考慮哪些方面的因素呢 2016-10-30