Python爬蟲:爬取小說并存儲(chǔ)到數(shù)據(jù)庫-創(chuàng)新互聯(lián)

爬取小說網(wǎng)站的小說,并保存到數(shù)據(jù)庫

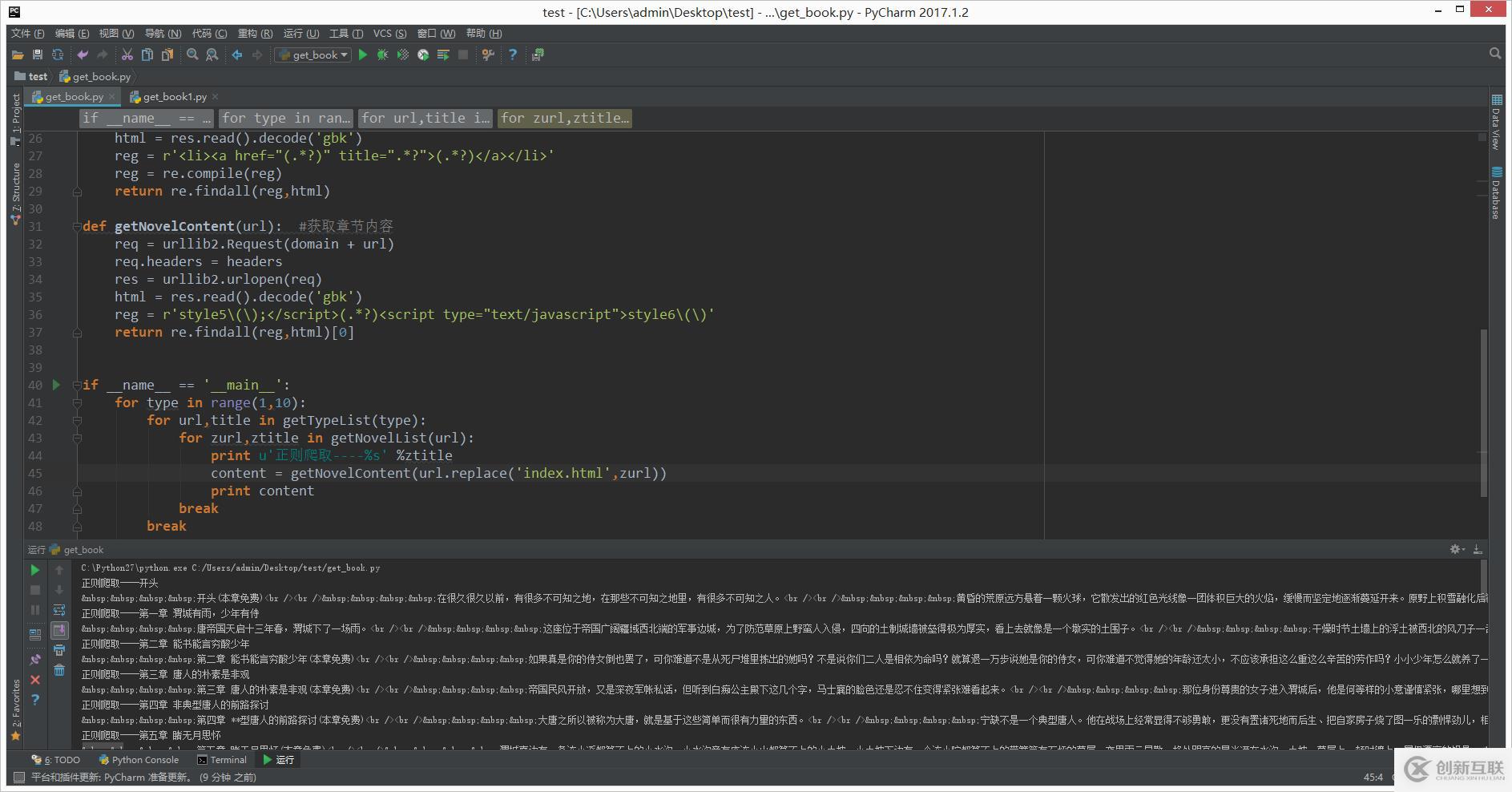

第一步:先獲取小說內(nèi)容

#!/usr/bin/python # -*- coding: UTF-8 -*- import urllib2,re domain = 'http://www.quanshu.net' headers = { "User-Agent": "Mozilla/5.0 (Windows NT 6.3; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36" } def getTypeList(pn=1): #獲取分類列表的函數(shù) req = urllib2.Request('http://www.quanshu.net/map/%s.html' % pn) #實(shí)例將要請(qǐng)求的對(duì)象 req.headers = headers #替換所有頭信息 #req.add_header() #添加單個(gè)頭信息 res = urllib2.urlopen(req) #開始請(qǐng)求 html = res.read().decode('gbk') #decode解碼,解碼成Unicode reg = r'<a href="(/book/.*?)" target="_blank">(.*?)</a>' reg = re.compile(reg) #增加匹配效率 正則匹配返回的類型為List return re.findall(reg,html) def getNovelList(url): #獲取章節(jié)列表函數(shù) req = urllib2.Request(domain + url) req.headers = headers res = urllib2.urlopen(req) html = res.read().decode('gbk') reg = r'<li><a href="(.*?)" title=".*?">(.*?)</a></li>' reg = re.compile(reg) return re.findall(reg,html) def getNovelContent(url): #獲取章節(jié)內(nèi)容 req = urllib2.Request(domain + url) req.headers = headers res = urllib2.urlopen(req) html = res.read().decode('gbk') reg = r'style5\(\);</script>(.*?)<script type="text/javascript">style6\(\)' return re.findall(reg,html)[0] if __name__ == '__main__': for type in range(1,10): for url,title in getTypeList(type): for zurl,ztitle in getNovelList(url): print u'正則爬取----%s' %ztitle content = getNovelContent(url.replace('index.html',zurl)) print content break break執(zhí)行后結(jié)果如下:

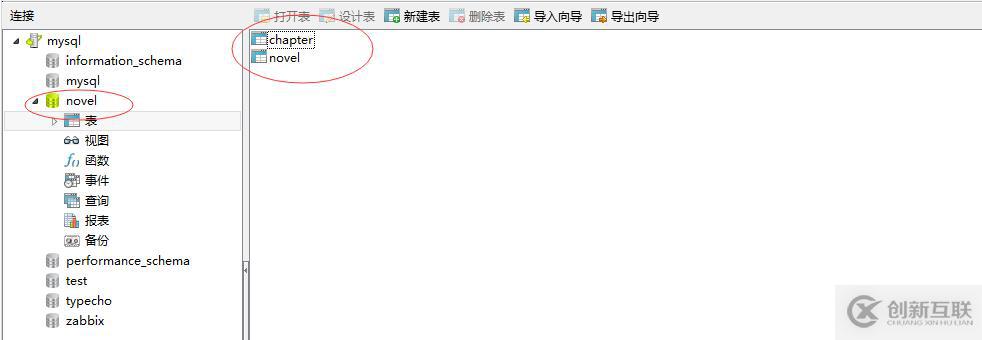

第二步:存儲(chǔ)到數(shù)據(jù)庫

1、設(shè)計(jì)數(shù)據(jù)庫

1.1 新建庫:novel

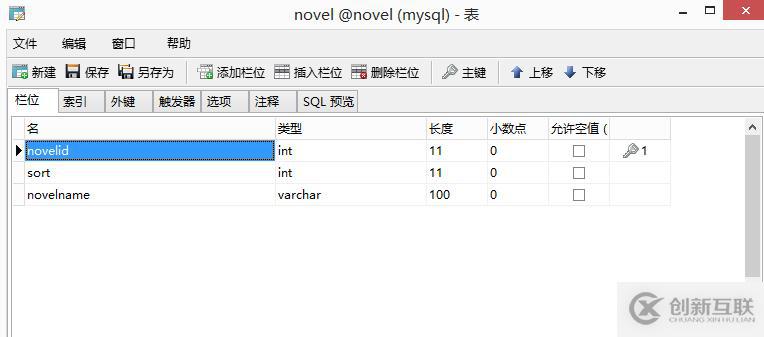

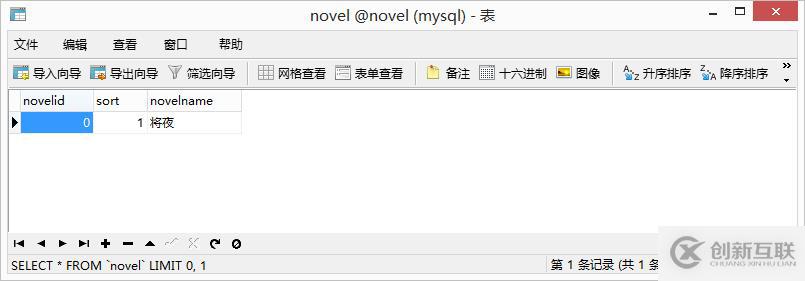

1.2 設(shè)計(jì)表:novel

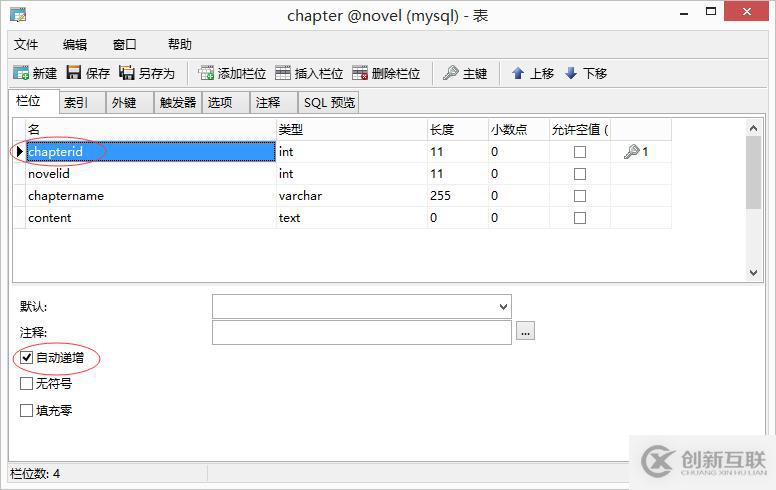

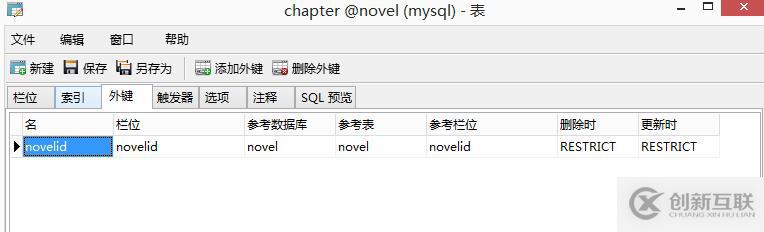

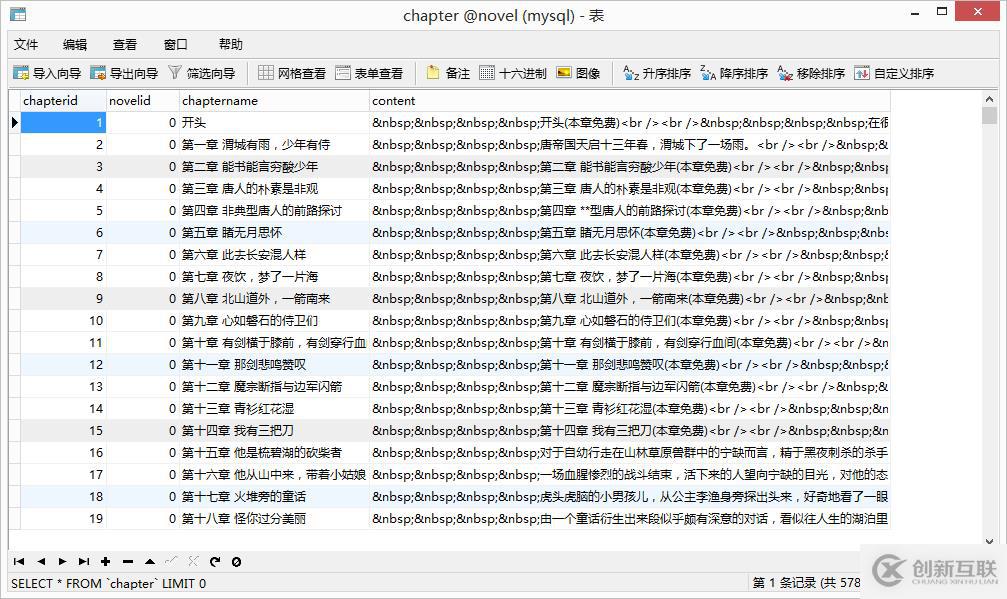

1.3 設(shè)計(jì)表:chapter

并設(shè)置外鍵

2、編寫腳本

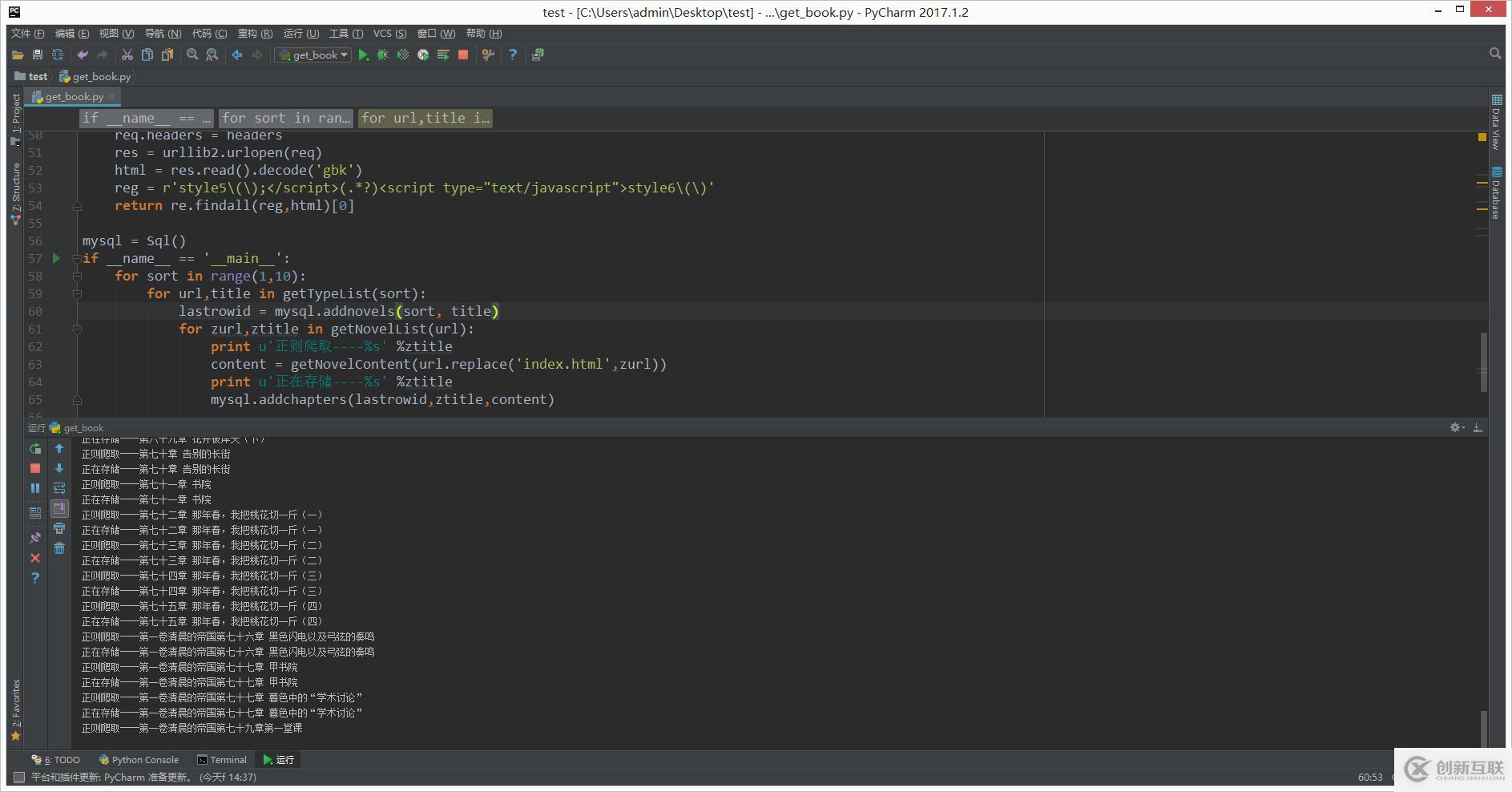

#!/usr/bin/python # -*- coding: UTF-8 -*- import urllib2,re import MySQLdb class Sql(object): conn = MySQLdb.connect(host='192.168.19.213',port=3306,user='root',passwd='Admin123',db='novel',charset='utf8') def addnovels(self,sort,novelname): cur = self.conn.cursor() cur.execute("insert into novel(sort,novelname) values(%s , '%s')" %(sort,novelname)) lastrowid = cur.lastrowid cur.close() self.conn.commit() return lastrowid def addchapters(self,novelid,chaptername,content): cur = self.conn.cursor() cur.execute("insert into chapter(novelid,chaptername,content) values(%s , '%s' ,'%s')" %(novelid,chaptername,content)) cur.close() self.conn.commit() domain = 'http://www.quanshu.net' headers = { "User-Agent": "Mozilla/5.0 (Windows NT 6.3; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36" } def getTypeList(pn=1): #獲取分類列表的函數(shù) req = urllib2.Request('http://www.quanshu.net/map/%s.html' % pn) #實(shí)例將要請(qǐng)求的對(duì)象 req.headers = headers #替換所有頭信息 #req.add_header() #添加單個(gè)頭信息 res = urllib2.urlopen(req) #開始請(qǐng)求 html = res.read().decode('gbk') #decode解碼,解碼成Unicode reg = r'<a href="(/book/.*?)" target="_blank">(.*?)</a>' reg = re.compile(reg) #增加匹配效率 正則匹配返回的類型為List return re.findall(reg,html) def getNovelList(url): #獲取章節(jié)列表函數(shù) req = urllib2.Request(domain + url) req.headers = headers res = urllib2.urlopen(req) html = res.read().decode('gbk') reg = r'<li><a href="(.*?)" title=".*?">(.*?)</a></li>' reg = re.compile(reg) return re.findall(reg,html) def getNovelContent(url): #獲取章節(jié)內(nèi)容 req = urllib2.Request(domain + url) req.headers = headers res = urllib2.urlopen(req) html = res.read().decode('gbk') reg = r'style5\(\);</script>(.*?)<script type="text/javascript">style6\(\)' return re.findall(reg,html)[0] mysql = Sql() if __name__ == '__main__': for sort in range(1,10): for url,title in getTypeList(sort): lastrowid = mysql.addnovels(sort, title) for zurl,ztitle in getNovelList(url): print u'正則爬取----%s' %ztitle content = getNovelContent(url.replace('index.html',zurl)) print u'正在存儲(chǔ)----%s' %ztitle mysql.addchapters(lastrowid,ztitle,content)3、執(zhí)行腳本

4、查看數(shù)據(jù)庫

可以看到已經(jīng)存儲(chǔ)成功了。

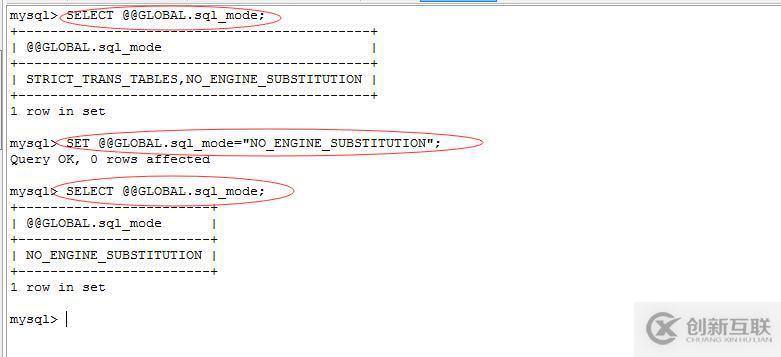

報(bào)錯(cuò):

_mysql_exceptions.OperationalError: (1364, "Field 'novelid' doesn't have a default value")

解決:執(zhí)行sql語句

SELECT @@GLOBAL.sql_mode;

SET @@GLOBAL.sql_mode="NO_ENGINE_SUBSTITUTION";

報(bào)錯(cuò)參考:http://blog.sina.com.cn/s/blog_6d2b3e4901011j9w.html

另外有需要云服務(wù)器可以了解下創(chuàng)新互聯(lián)cdcxhl.cn,海內(nèi)外云服務(wù)器15元起步,三天無理由+7*72小時(shí)售后在線,公司持有idc許可證,提供“云服務(wù)器、裸金屬服務(wù)器、高防服務(wù)器、香港服務(wù)器、美國服務(wù)器、虛擬主機(jī)、免備案服務(wù)器”等云主機(jī)租用服務(wù)以及企業(yè)上云的綜合解決方案,具有“安全穩(wěn)定、簡單易用、服務(wù)可用性高、性價(jià)比高”等特點(diǎn)與優(yōu)勢,專為企業(yè)上云打造定制,能夠滿足用戶豐富、多元化的應(yīng)用場景需求。

網(wǎng)站欄目:Python爬蟲:爬取小說并存儲(chǔ)到數(shù)據(jù)庫-創(chuàng)新互聯(lián)

轉(zhuǎn)載來源:http://chinadenli.net/article18/dspodp.html

成都網(wǎng)站建設(shè)公司_創(chuàng)新互聯(lián),為您提供電子商務(wù)、小程序開發(fā)、網(wǎng)站排名、網(wǎng)站內(nèi)鏈、網(wǎng)站導(dǎo)航、建站公司

聲明:本網(wǎng)站發(fā)布的內(nèi)容(圖片、視頻和文字)以用戶投稿、用戶轉(zhuǎn)載內(nèi)容為主,如果涉及侵權(quán)請(qǐng)盡快告知,我們將會(huì)在第一時(shí)間刪除。文章觀點(diǎn)不代表本網(wǎng)站立場,如需處理請(qǐng)聯(lián)系客服。電話:028-86922220;郵箱:631063699@qq.com。內(nèi)容未經(jīng)允許不得轉(zhuǎn)載,或轉(zhuǎn)載時(shí)需注明來源: 創(chuàng)新互聯(lián)

猜你還喜歡下面的內(nèi)容

- web分布式系統(tǒng)怎么理解-創(chuàng)新互聯(lián)

- 在Linux系統(tǒng)上怎么實(shí)現(xiàn)IP轉(zhuǎn)發(fā)-創(chuàng)新互聯(lián)

- Golang框架與Web框架的對(duì)比-創(chuàng)新互聯(lián)

- 原生ajax如何變參數(shù)post-創(chuàng)新互聯(lián)

- mysql實(shí)現(xiàn)數(shù)據(jù)切分的方法-創(chuàng)新互聯(lián)

- 揭秘LOL背后的IT基礎(chǔ)設(shè)施丨關(guān)鍵角色“調(diào)度”-創(chuàng)新互聯(lián)

- react引入css的方法-創(chuàng)新互聯(lián)

- 如何做好品牌網(wǎng)站制作 2021-11-16

- 為什么高端品牌網(wǎng)站制作公司越來越少了 2016-11-12

- 品牌網(wǎng)站制作為什么只能選擇網(wǎng)站定制 2021-10-04

- 品牌網(wǎng)站制作常見的布局方式! 2022-05-11

- SEO優(yōu)化如何才能戰(zhàn)勝競爭對(duì)手 2022-06-04

- 企業(yè)品牌網(wǎng)站制作要注重哪些問題? 2023-04-18

- 品牌網(wǎng)站制作好方法好步驟? 2021-06-03

- 品牌網(wǎng)站制作方案要怎么做 2021-08-28

- 中小企業(yè)品牌網(wǎng)站制作與塑造 2021-12-06

- 高端品牌網(wǎng)站制作策劃方案 2021-10-09

- 集團(tuán)型網(wǎng)站建設(shè)品牌網(wǎng)站制作設(shè)計(jì) 2020-12-03

- 什么是品牌網(wǎng)站,品牌網(wǎng)站制作需要注意哪些內(nèi)容? 2016-10-15