利用Python爬蟲怎么對筆趣閣小說進(jìn)行爬取-創(chuàng)新互聯(lián)

今天就跟大家聊聊有關(guān)利用Python爬蟲怎么對筆趣閣小說進(jìn)行爬取,可能很多人都不太了解,為了讓大家更加了解,小編給大家總結(jié)了以下內(nèi)容,希望大家根據(jù)這篇文章可以有所收獲。

創(chuàng)新互聯(lián)公司長期為上千余家客戶提供的網(wǎng)站建設(shè)服務(wù),團(tuán)隊從業(yè)經(jīng)驗10年,關(guān)注不同地域、不同群體,并針對不同對象提供差異化的產(chǎn)品和服務(wù);打造開放共贏平臺,與合作伙伴共同營造健康的互聯(lián)網(wǎng)生態(tài)環(huán)境。為洛南企業(yè)提供專業(yè)的網(wǎng)站設(shè)計、成都網(wǎng)站建設(shè),洛南網(wǎng)站改版等技術(shù)服務(wù)。擁有10多年豐富建站經(jīng)驗和眾多成功案例,為您定制開發(fā)。基本開發(fā)環(huán)境

Python 3.6

Pycharm

相關(guān)模塊的使用

request

sparsel

安裝Python并添加到環(huán)境變量,pip安裝需要的相關(guān)模塊即可。

單章爬取

一、明確需求

爬取小說內(nèi)容保存到本地

小說名字

小說章節(jié)名字

小說內(nèi)容

# 第一章小說url地址 url = 'http://www.biquges.com/52_52642/25585323.html'

url = 'http://www.biquges.com/52_52642/25585323.html'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.138 Safari/537.36'

}

response = requests.get(url=url, headers=headers)

print(response.text)

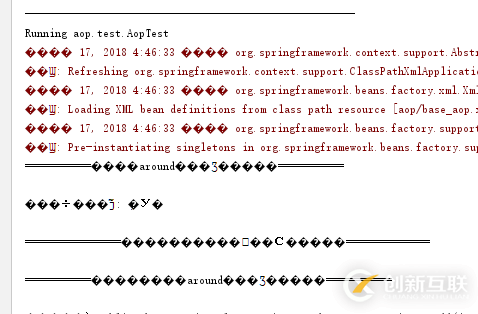

請求網(wǎng)頁返回的數(shù)據(jù)中出現(xiàn)了亂碼,這就需要我們轉(zhuǎn)碼了。

加一行代碼自動轉(zhuǎn)碼。

response.encoding = response.apparent_encoding

三、解析數(shù)據(jù)

根據(jù)css選擇器可以直接提取小說標(biāo)題以及小說內(nèi)容。

def get_one_novel(html_url):

# 調(diào)用請求網(wǎng)頁數(shù)據(jù)函數(shù)

response = get_response(html_url)

# 轉(zhuǎn)行成selector解析對象

selector = parsel.Selector(response.text)

# 獲取小說標(biāo)題

title = selector.css('.bookname h2::text').get()

# 獲取小說內(nèi)容 返回的是list

content_list = selector.css('#content::text').getall()

# ''.join(列表) 把列表轉(zhuǎn)換成字符串

content_str = ''.join(content_list)

print(title, content_str)

if __name__ == '__main__':

url = 'http://www.biquges.com/52_52642/25585323.html'

get_one_novel(url)

四、保存數(shù)據(jù)(數(shù)據(jù)持久化)

使用常用的保存方式:with open

def save(title, content):

"""

保存小說

:param title: 小說章節(jié)標(biāo)題

:param content: 小說內(nèi)容

:return:

"""

# 路徑

filename = f'{title}\\'

# os 內(nèi)置模塊,自動創(chuàng)建文件夾

if os.makedirs(filename):

os.mkdir()

# 一定要記得加后綴 .txt mode 保存方式 a 是追加保存 encoding 保存編碼

with open(filename + title + '.txt', mode='a', encoding='utf-8') as f:

# 寫入標(biāo)題

f.write(title)

# 換行

f.write('\n')

# 寫入小說內(nèi)容

f.write(content)

保存一章小說,就這樣寫完了,如果想要保存整本小說呢?

整本小說爬蟲

既然爬取單章小說知道怎么爬取了,那么只需要獲取小說所有單章小說的url地址,就可以爬取全部小說內(nèi)容了。

所有的單章的url地址都在 dd 標(biāo)簽當(dāng)中,但是這個url地址是不完整的,所以爬取下來的時候,要拼接url地址。

def get_all_url(html_url):

# 調(diào)用請求網(wǎng)頁數(shù)據(jù)函數(shù)

response = get_response(html_url)

# 轉(zhuǎn)行成selector解析對象

selector = parsel.Selector(response.text)

# 所有的url地址都在 a 標(biāo)簽里面的 href 屬性中

dds = selector.css('#list dd a::attr(href)').getall()

for dd in dds:

novel_url = 'http://www.biquges.com' + dd

print(novel_url)

if __name__ == '__main__':

url = 'http://www.biquges.com/52_52642/index.html'

get_all_url(url)

這樣就獲取了所有的小說章節(jié)url地址了。

爬取全本完整代碼

import requests

import parsel

from tqdm import tqdm

def get_response(html_url):

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.138 Safari/537.36'

}

response = requests.get(url=html_url, headers=headers)

response.encoding = response.apparent_encoding

return response

def save(novel_name, title, content):

"""

保存小說

:param title: 小說章節(jié)標(biāo)題

:param content: 小說內(nèi)容

:return:

"""

filename = f'{novel_name}' + '.txt'

# 一定要記得加后綴 .txt mode 保存方式 a 是追加保存 encoding 保存編碼

with open(filename, mode='a', encoding='utf-8') as f:

# 寫入標(biāo)題

f.write(title)

# 換行

f.write('\n')

# 寫入小說內(nèi)容

f.write(content)

def get_one_novel(name, novel_url):

# 調(diào)用請求網(wǎng)頁數(shù)據(jù)函數(shù)

response = get_response(novel_url)

# 轉(zhuǎn)行成selector解析對象

selector = parsel.Selector(response.text)

# 獲取小說標(biāo)題

title = selector.css('.bookname h2::text').get()

# 獲取小說內(nèi)容 返回的是list

content_list = selector.css('#content::text').getall()

# ''.join(列表) 把列表轉(zhuǎn)換成字符串

content_str = ''.join(content_list)

save(name, title, content_str)

def get_all_url(html_url):

# 調(diào)用請求網(wǎng)頁數(shù)據(jù)函數(shù)

response = get_response(html_url)

# 轉(zhuǎn)行成selector解析對象

selector = parsel.Selector(response.text)

# 所有的url地址都在 a 標(biāo)簽里面的 href 屬性中

dds = selector.css('#list dd a::attr(href)').getall()

# 小說名字

novel_name = selector.css('#info h2::text').get()

for dd in tqdm(dds):

novel_url = 'http://www.biquges.com' + dd

get_one_novel(novel_name, novel_url)

if __name__ == '__main__':

novel_id = input('輸入書名ID:')

url = f'http://www.biquges.com/{novel_id}/index.html'

get_all_url(url)

看完上述內(nèi)容,你們對利用Python爬蟲怎么對筆趣閣小說進(jìn)行爬取有進(jìn)一步的了解嗎?如果還想了解更多知識或者相關(guān)內(nèi)容,請關(guān)注創(chuàng)新互聯(lián)行業(yè)資訊頻道,感謝大家的支持。

本文名稱:利用Python爬蟲怎么對筆趣閣小說進(jìn)行爬取-創(chuàng)新互聯(lián)

文章路徑:http://chinadenli.net/article18/ceocdp.html

成都網(wǎng)站建設(shè)公司_創(chuàng)新互聯(lián),為您提供網(wǎng)站收錄、App設(shè)計、營銷型網(wǎng)站建設(shè)、響應(yīng)式網(wǎng)站、移動網(wǎng)站建設(shè)、網(wǎng)站維護(hù)

聲明:本網(wǎng)站發(fā)布的內(nèi)容(圖片、視頻和文字)以用戶投稿、用戶轉(zhuǎn)載內(nèi)容為主,如果涉及侵權(quán)請盡快告知,我們將會在第一時間刪除。文章觀點(diǎn)不代表本網(wǎng)站立場,如需處理請聯(lián)系客服。電話:028-86922220;郵箱:631063699@qq.com。內(nèi)容未經(jīng)允許不得轉(zhuǎn)載,或轉(zhuǎn)載時需注明來源: 創(chuàng)新互聯(lián)

猜你還喜歡下面的內(nèi)容

- 網(wǎng)頁設(shè)計公司分享做網(wǎng)站常見的10大問題 2022-05-04

- 網(wǎng)頁設(shè)計公司不能犯的錯誤 2016-10-28

- 在選擇網(wǎng)頁設(shè)計公司之前要問的10個問題 2022-08-06

- 教您如何選擇好的成都網(wǎng)頁設(shè)計公司 2017-01-20

- 網(wǎng)頁設(shè)計公司怎樣制作網(wǎng)頁 2022-11-29

- 好的網(wǎng)頁設(shè)計公司如何選擇網(wǎng)絡(luò)空間? 2022-08-03

- 我該怎么選擇網(wǎng)頁設(shè)計公司? 2019-06-19

- 如何選擇一個網(wǎng)頁設(shè)計公司 2022-10-14

- 尋求專業(yè)網(wǎng)頁設(shè)計公司的好處 2022-10-31

- 選擇網(wǎng)頁設(shè)計公司:要考慮的5件事 2022-09-15

- 河內(nèi)最具聲望的三家網(wǎng)頁設(shè)計公司 2019-03-18

- 楊浦網(wǎng)頁設(shè)計公司:網(wǎng)站優(yōu)化_網(wǎng)站建設(shè)_關(guān)鍵詞排名 2020-11-16