spark+kafka+redis統(tǒng)計網(wǎng)站訪問者IP-創(chuàng)新互聯(lián)

*目的是為了防采集。需要對網(wǎng)站的日志信息,進行一個實時的IP訪問監(jiān)控。

1、kafka版本是最新的0.10.0.0

2、spark版本是1.61

3、下載對應(yīng)的spark-streaming-kafka-assembly_2.10-1.6.1.jar放到spark目錄下的lib目錄下

下載地址 https://repo1.maven.org/maven2/org/apache/spark/

4、利用flume將nginx日志寫入到kafka(后續(xù)補充)

5、編寫python腳本,命名為test_spark_collect_ip.py

# coding:utf-8

__author__ = 'chenhuachao'

'''

利用pyspark連接kafka,統(tǒng)計訪問者的IP信息,做出的一個實時的防采集

'''

import sys

reload(sys)

sys.setdefaultencoding('utf-8')

import redis

import datetime

from pyspark.streaming.kafka import KafkaUtils

from pyspark.streaming import StreamingContext

from pyspark import SparkConf, SparkContext

def parse(logstring):

try:

infodict = eval(logstring.encode('utf-8'))

ip =infodict.get('ip')

assert infodict['tj-event'] == 'onload'

assert ip

return (ip)

except:

return ()

def insert_redis(rdd):

'''將符合條件的結(jié)果寫入到redis'''

conn = redis.Redis(host='redis的IP',port=6380)

for i,j in rdd.collect():

print i,j

if j >=3 and j != "":

conn.sadd('cheating_ip_set_{0}'.format(datetime.datetime.now().strftime("%Y%m%d")),i)

conn.expire('cheating_ip_set',86400)

if __name__ == "__main__":

topic = 'statis-detailinfo-pageevent'

sc = SparkContext(appName="pyspark_kafka_streaming_chc")

ssc = StreamingContext(sc,10)

checkpointDirectory = '/tmp/checkpoint/cp3'

ssc.checkpoint(checkpointDirectory)

kvs = KafkaUtils.createDirectStream(ssc,['statis-detailinfo-pageevent'],kafkaParams={"auto.offset.reset": "largest","metadata.broker.list":"kafka-IP:9092,kafka-IP:9092"})

#kvs.map(lambda line:line[1]).map(lambda x:parse(x)).pprint()

#這里用到了一個滑動窗口的概念,需要深入了解的可以參考http://www.kancloud.cn/kancloud/spark-programming-guide/51567

#ipcount = kvs.map(lambda line: line[1]).map(lambda x:parse(x)).map(lambda ip:(ip,1)).reduceByKey(lambda ips,num:ips+num)

ipcount = kvs.map(lambda line: line[1]).map(lambda x:parse(x)).map(lambda ip:(ip,1)).reduceByKeyAndWindow(lambda ips,num:ips+num,30,10)

# 預(yù)處理,如果需要多次計算則使用緩存

# 傳入rdd進行循壞,即用于foreachRdd(insertRedis)

ipcount.foreachRDD(insert_redis)

# 各節(jié)點的rdd的循壞

# wordCounts.foreachRDD(lambda rdd: rdd.foreach(sendRecord))

ssc.start()6、執(zhí)行命令

bin/spark-submit --jars lib/spark-streaming-kafka-assembly_2.10-1.6.1.jar test_spark_collect_ip.py

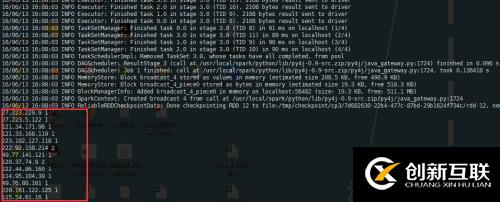

7、輸出界面

8、更多信息,請參考spark的官網(wǎng)http://spark.apache.org/docs/latest/api/python/pyspark.streaming.html#module-pyspark.streaming.kafka

另外有需要云服務(wù)器可以了解下創(chuàng)新互聯(lián)scvps.cn,海內(nèi)外云服務(wù)器15元起步,三天無理由+7*72小時售后在線,公司持有idc許可證,提供“云服務(wù)器、裸金屬服務(wù)器、高防服務(wù)器、香港服務(wù)器、美國服務(wù)器、虛擬主機、免備案服務(wù)器”等云主機租用服務(wù)以及企業(yè)上云的綜合解決方案,具有“安全穩(wěn)定、簡單易用、服務(wù)可用性高、性價比高”等特點與優(yōu)勢,專為企業(yè)上云打造定制,能夠滿足用戶豐富、多元化的應(yīng)用場景需求。

文章標(biāo)題:spark+kafka+redis統(tǒng)計網(wǎng)站訪問者IP-創(chuàng)新互聯(lián)

分享網(wǎng)址:http://chinadenli.net/article18/diiogp.html

成都網(wǎng)站建設(shè)公司_創(chuàng)新互聯(lián),為您提供網(wǎng)站內(nèi)鏈、定制開發(fā)、虛擬主機、標(biāo)簽優(yōu)化、關(guān)鍵詞優(yōu)化、微信小程序

聲明:本網(wǎng)站發(fā)布的內(nèi)容(圖片、視頻和文字)以用戶投稿、用戶轉(zhuǎn)載內(nèi)容為主,如果涉及侵權(quán)請盡快告知,我們將會在第一時間刪除。文章觀點不代表本網(wǎng)站立場,如需處理請聯(lián)系客服。電話:028-86922220;郵箱:631063699@qq.com。內(nèi)容未經(jīng)允許不得轉(zhuǎn)載,或轉(zhuǎn)載時需注明來源: 創(chuàng)新互聯(lián)

猜你還喜歡下面的內(nèi)容

- 如何通過搜索引擎優(yōu)化數(shù)據(jù)網(wǎng)站seo優(yōu)化內(nèi)容? 2014-02-27

- 企業(yè)網(wǎng)站搜索引擎優(yōu)化自檢指導(dǎo) 2023-03-07

- 搜索引擎優(yōu)化如何提供良好的結(jié)果? 2014-03-07

- 網(wǎng)站建設(shè)時理應(yīng)考慮到的seo搜索引擎優(yōu)化問題 2021-12-01

- 如果要達到排名的關(guān)鍵字被合理定位,搜索引擎優(yōu)化會成功一半以上 2023-04-14

- 如何進行搜索引擎優(yōu)化? 2013-04-28

- 7個使用彈窗且不影響搜索引擎優(yōu)化的技巧 2022-06-18

- URL地址重寫和搜索引擎優(yōu)化 2022-07-07

- 中小企業(yè)網(wǎng)站都應(yīng)該重視搜索引擎優(yōu)化 2021-01-08

- 談?wù)劸W(wǎng)站SEO搜索引擎優(yōu)化以后發(fā)展趨勢 2016-05-16

- 什么是搜索引擎優(yōu)化(SEO)及其好處 2022-11-15

- 搜索引擎優(yōu)化帶來流量 2021-09-07